Sam Altman lance la chasse aux scénarios apocalyptiques : OpenAI recrute un chef de la préparation pour éviter que l’IA ne déraille

OpenAI recrute un « Head of Preparedness » : comment prévenir les pires scénarios liés à l’IA

Sam Altman a publié une offre surprenante et sans fard : OpenAI recherche un « Head of Preparedness », littéralement un responsable chargé d’anticiper et de préparer l’organisation aux risques majeurs liés à l’intelligence artificielle. L’annonce est révélatrice d’un double mouvement : la reconnaissance publique des dangers potentiels des modèles d’IA, et la tentative d’installer des garde‑fous depuis l’intérieur même des entreprises qui développent ces technologies.

Un poste dédié aux « scénarios apocalyptiques » : de quoi parle‑t‑on ?

Le rôle n’a rien d’anecdotique. Il s’agit de concevoir des évaluations de capacités, de modéliser des menaces plausibles et d’établir des mesures de mitigation opérationnelles et évolutives. Concrètement, le responsable devra imaginer comment une IA pourrait :

Il n’est pas question de fiction : ces risques se fondent sur des capacités déjà observées ou plausibles à court/moyen terme. L’objectif de la mission est de rendre ces risques identifiables, mesurables et atténuables avant qu’ils ne deviennent incontrôlables.

Pourquoi ce poste maintenant ?

Plusieurs raisons expliquent l’urgence affichée par OpenAI :

Quelles compétences pour ce « Head of Preparedness » ?

Le profil recherché devra être hybride : analytique, technique et stratégique. Parmi les compétences attendues :

Le poste implique aussi d’anticiper la gouvernance : définir quand et comment bloquer, limiter ou retarder la mise en production d’un modèle présentant des « capacités sensibles ». C’est un pouvoir à poids lourd, qui exige des règles claires et un processus décisionnel transparent.

Les paradoxes et les critiques : trop tard ?

Recruter un « responsable des pires scénarios » suscite une question simple : pourquoi ce rôle n’a‑t‑il pas existé dès les premières étapes de développement ? Plusieurs éléments nourrissent la critique :

Malgré ces critiques, la réalité est que la dynamique actuelle impose de mettre en place immédiatement des moyens de prévention robustes. L’inaction aurait des coûts humains et sociaux potentiellement considérables.

Quels outils pour anticiper et contenir les risques ?

Le « Head of Preparedness » devra déployer une boîte à outils opérationnelle :

Il faudra également imaginer des mécanismes institutionnels : panels d’experts externes, audits régulatoires et coopérations internationales pour partager les signaux d’alerte et harmoniser les réponses.

Impacts attendus et points de vigilance

Si bien menées, ces démarches peuvent réduire des risques concrets et renforcer la confiance publique. Mais plusieurs conditions sont nécessaires :

L’embauche d’un « Head of Preparedness » est une avancée, mais elle n’est utile que si elle s’accompagne d’institutions, de ressources et d’un engagement réel à prioriser la sécurité face à la course au marché.

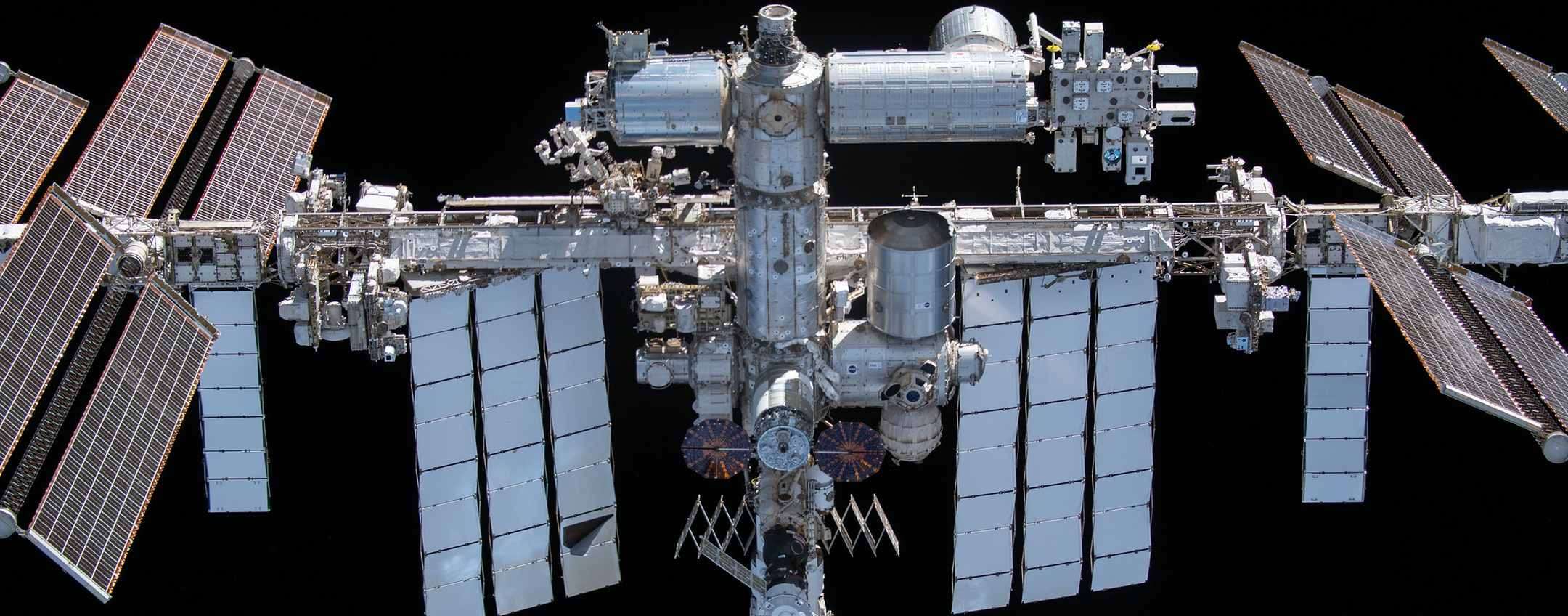

Les enjeux plus larges

La nomination d’un tel poste chez OpenAI est aussi un signal politique : la société reconnait que le développement de l’IA ne peut être piloté uniquement par des logiques d’innovation produit. Il s’agit d’un enjeu de société, qui nécessite coopération internationale, cadres réglementaires clairs et investissements dans la résilience sociale. À défaut, la dissociation entre capacité technologique et gouvernance risque d’engendrer des externalités dangereuses — auxquelles, ironie du sort, il faudra encore une fois répondre « après » plutôt qu’« avant ».